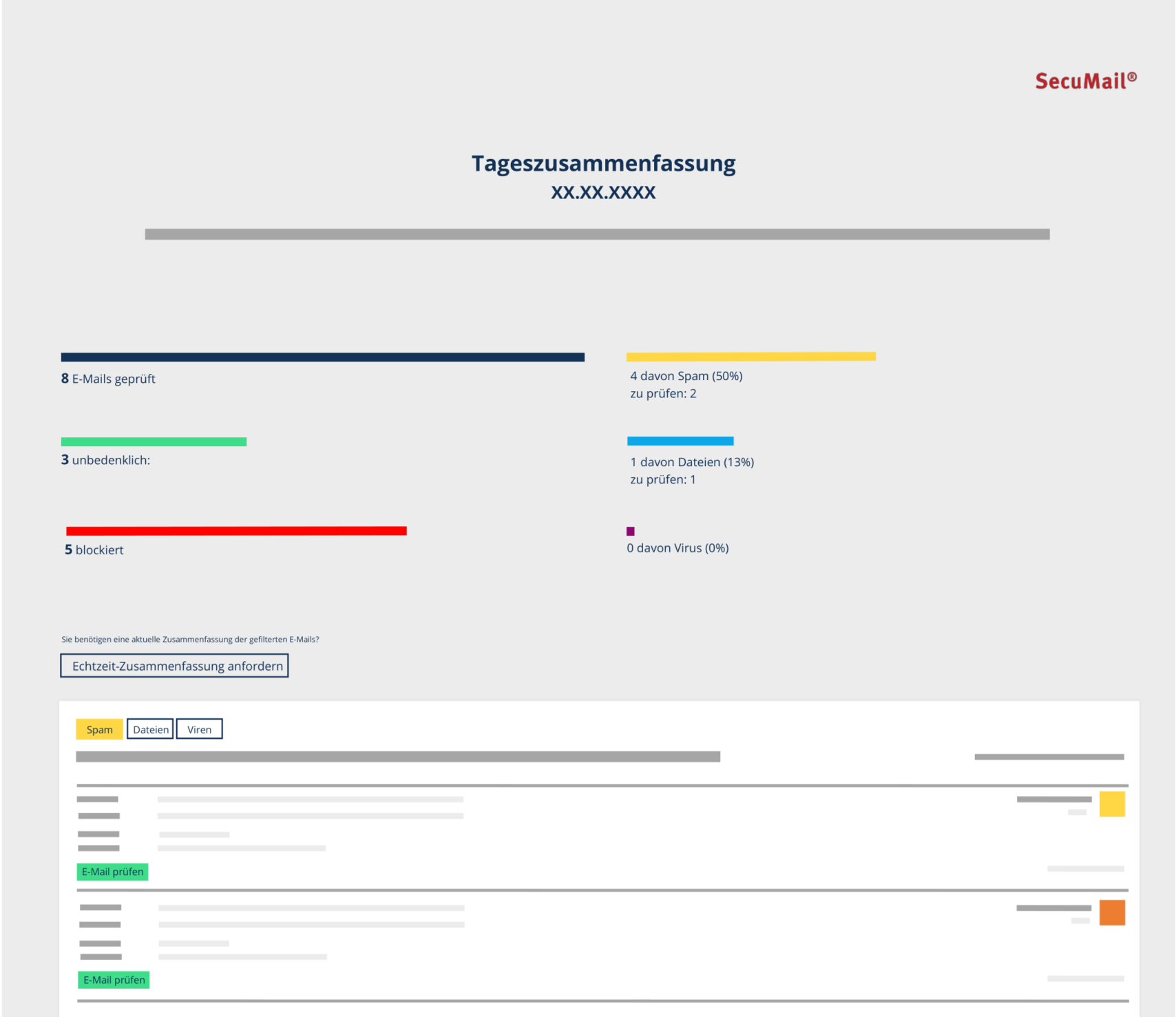

E-Mail-Sicherheit leicht gemacht! Die SecuMail® Tageszusammenfassung im neuen Layout

E-Mail-Sicherheit leicht gemacht! Um die Anwendung des SecuMail® Filters für unsere Kunden noch bequemer zu gestalten, haben wir die Tageszusammenfassung weiter optimiert. …

Mehr lesenE-Mail-Sicherheit leicht gemacht! Die SecuMail® Tageszusammenfassung im neuen Layout